L’IA dans la gendarmerie

Pour faire face à l’évolution de la cybercriminalité et assister le gendarme dans ses tâches quotidiennes, la Gendarmerie nationale se forme et utilise l’intelligence artificielle. Le point avec Général Patrick Perrot, conseiller IA auprès du commandement du ministère de l’intérieur dans le cyber espace.

Comment appréhendez-vous l’IA à la Gendarmerie nationale ?

Patrick Perrot. Nous avons construit depuis 4 ans une stratégie qui repose sur quatre piliers :

- la formation : cela va de l’acculturation des gendarmes et des citoyens avec une revue bimestrielle Cultur’IA que l’on publie depuis 4 ans pour expliquer l’IA dans le champ de la sécurité intérieure jusqu’à la thèse de doctorat. On a créé une chaire IA et sécurité avec l’Institut supérieur électronique de Paris qui permet d’avoir des parcours doctoraux dans le domaine de l’IA. On fait aussi des formations auprès des forces de sécurité européennes par exemple ;

- l’éthique, la réglementation et la conformité. Nous avons publié une charte éthique en 2021, participé aux discussions autour de l’IA Act et à l’expérimentation JOP 2024. Pour la conformité, nous avons une politique d’assurance qualité, très orientée sur l’analyse des risques systémiques de l’IA, à savoir les risques cyber et ceux sur les droits fondamentaux ;

- les partenariats et la valorisation : l’idée c’est de ne pas travailler tout seul, d’avoir des partenariats avec des think tanks pour une ouverture sur la société, avec des industriels pour voir la capacité à développer nos systèmes, avec des centres de recherche pour anticiper les menaces à venir. C’est un devoir de redevabilité et de transparence. Si on associe IA et sécurité intérieure, on voit très vite Minority Report et le fantasme de la société de surveillance. Nous voulons expliquer ce que l’on fait ;

- la recherche et le développement d’outils opérationnels. Il est essentiel de pouvoir avoir la maitrise des conditions d’utilisation des systèmes d’IA et de leur compréhension et disposer d’outils sur mesure. C’est la raison pour laquelle, nous développons des applications qui ont vocation à répondre aux missions très spécifiques qui sont les nôtres. Cela n’empêche nullement bien entendu l’achat de solutions sur étagère.

En IA, vous l’aurez compris, il est essentiel d’avoir une vision pour anticiper les bouleversements à venir de la criminalité en veillant à prévenir toute myopie stratégique encouragée par les effets de mode qui ne manquent pas.

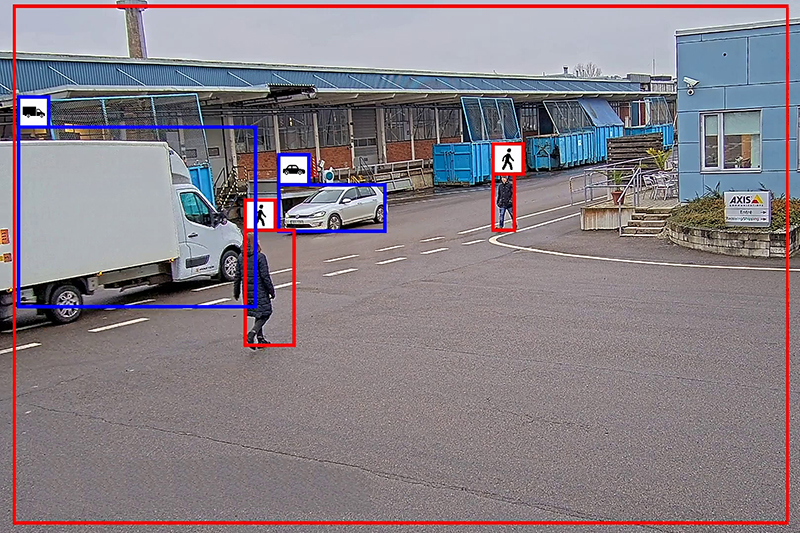

Quels sont ces outils développés en interne ?

Continuez votre lecture… Abonnez-vous !

Si vous êtes déjà abonné, connectez-vous.

En ce moment

Ce numéro 612 de Face au Risque consacre un dossier spécial à la traçabilité des agents CMR (cancérogènes, mutagènes,…

Les accidents de trajet mortels entrent-ils dans le champ d’application de l’obligation pour l’employeur d’informer dans les douze heures…

Protéger ses innovations relève autant de la stratégie que de la sûreté de l’entreprise. Brevets, marques, dessins et modèles permettent…

La directive (UE) 2026/470 portant modification de la directive relative à la publication d’informations sur la durabilité des entreprises…

CNPP, acteur de référence en matière de prévention et de maîtrise des risques, et BatiFire éditeur de logiciels, sont partenaires…

Depuis janvier 2026, EDF interdit la consommation d’alcool au travail et lors des événements professionnels. Cette décision, qui renvoie…